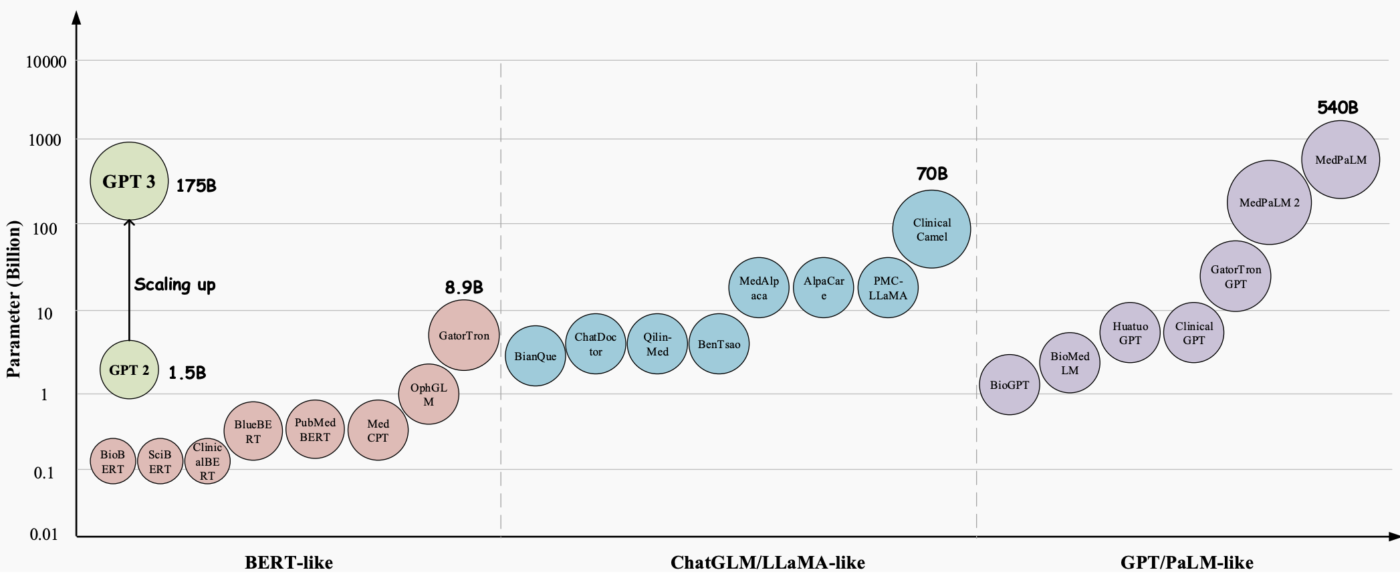

Come afferma Hugging Face, società specializzata in intelligenza artificiale e machine learning, nel corso degli anni i Large Language Models (LLM) sono emersi come una tecnologia innovativa con un immenso potenziale per rivoluzionare vari aspetti dell’assistenza sanitaria.

Questi modelli, come GPT-3, GPT-4 e Med-PaLM 2, hanno dimostrato notevoli capacità di comprensione e generazione di testi simili a quelli umani, rendendoli strumenti preziosi per affrontare compiti medici complessi e migliorare l’assistenza ai pazienti. In particolare, si sono dimostrati promettenti in diverse applicazioni mediche, come la risposta a domande (QA), i sistemi di dialogo e la generazione di testi. Inoltre, con la crescita esponenziale delle cartelle cliniche elettroniche (EHR), della letteratura medica e dei dati generati dai pazienti, le LLM potrebbero aiutare gli operatori sanitari a estrarre informazioni preziose e a prendere decisioni informate.

Tuttavia – mette altresì in evidenza Hugging Face –, nonostante l’immenso potenziale dei Large Language Models (LLM) nel settore sanitario, esistono sfide significative e specifiche che devono essere affrontate.

Quando i modelli vengono utilizzati per gli aspetti ludici della conversazione, gli errori hanno poche ripercussioni; non è così, invece, per gli usi in ambito medico, dove spiegazioni e risposte sbagliate possono avere gravi conseguenze per la cura e i risultati dei pazienti. L’accuratezza e l’affidabilità delle informazioni fornite dai modelli linguistici possono essere una questione di vita o di morte, in quanto possono potenzialmente influenzare le decisioni sanitarie, le diagnosi e i piani di trattamento.

Quando i modelli vengono utilizzati per gli aspetti ludici della conversazione, gli errori hanno poche ripercussioni; non è così, invece, per gli usi in ambito medico, dove spiegazioni e risposte sbagliate possono avere gravi conseguenze per la cura e i risultati dei pazienti. L’accuratezza e l’affidabilità delle informazioni fornite dai modelli linguistici possono essere una questione di vita o di morte, in quanto possono potenzialmente influenzare le decisioni sanitarie, le diagnosi e i piani di trattamento.

Per sfruttare appieno la potenza degli LLM in ambito sanitario, secondo Hugging Face è fondamentale sviluppare e sottoporre a benchmark i modelli utilizzando una configurazione specificamente progettata per il settore medico. Questa configurazione dovrebbe tenere conto delle caratteristiche e dei requisiti unici dei dati e delle applicazioni sanitarie. Lo sviluppo di metodi di valutazione degli LLM medici non è solo di interesse accademico, ma anche di importanza pratica, visti i rischi reali che essi comportano nel settore sanitario.

L’Open Medical LLM Leaderboard ha lo scopo di tracciare, classificare e valutare le prestazioni dei modelli linguistici di grandi dimensioni (LLM) su compiti di risposta a domande mediche. La classifica valuta gli LLM su una vasta gamma di set di dati medici, tra cui MedQA (USMLE), PubMedQA, MedMCQA e sottoinsiemi di MMLU relativi alla medicina e alla biologia. La leaderboard offre una valutazione completa delle conoscenze mediche e delle capacità di risposta alle domande di ciascun modello.

I set di dati coprono vari aspetti della medicina, come le conoscenze mediche generali, le conoscenze cliniche, l’anatomia, la genetica e altro ancora. Contengono domande a scelta multipla e aperte che richiedono un ragionamento e una comprensione di tipo medico.

L’Open Medical-LLM Leaderboard si propone dunque di affrontare tali sfide e limitazioni fornendo una piattaforma standardizzata per valutare e confrontare le prestazioni di vari modelli linguistici di grandi dimensioni su una vasta gamma di compiti e set di dati medici. Offrendo una valutazione completa delle conoscenze mediche e delle capacità di risposta alle domande di ciascun modello, la Leaderboard mira a promuovere lo sviluppo di LLM medici più efficaci e affidabili.

L’Open Medical-LLM Leaderboard si propone dunque di affrontare tali sfide e limitazioni fornendo una piattaforma standardizzata per valutare e confrontare le prestazioni di vari modelli linguistici di grandi dimensioni su una vasta gamma di compiti e set di dati medici. Offrendo una valutazione completa delle conoscenze mediche e delle capacità di risposta alle domande di ciascun modello, la Leaderboard mira a promuovere lo sviluppo di LLM medici più efficaci e affidabili.

Questa piattaforma – sottolinea Hugging Face – consente a ricercatori e professionisti di identificare i punti di forza e di debolezza dei diversi approcci, di promuovere ulteriori progressi nel campo e, in ultima analisi, di contribuire a migliorare le cure e i risultati per i pazienti.

Maggiori informazioni, dettagli tecnici e istruzioni su come fare il submit di un modello per la valutazione, sono disponibili sul sito di Hugging Face.